Los especialistas de McAfee han publicado un reporte sobre los sistemas de reconocimiento facial modernos y cómo pueden ser engañados explotando algunas fallas en el algoritmo de aprendizaje automático. En la investigación, titulada “Dopple-ganging up on Facial Recognition System”, los expertos aseguran que, abusando de estas fallas, el sistema confundirá a las personas con individuos completamente diferentes.

La compañía desarrolló un avanzado sistema de reconocimiento facial, muy similar al empleado por en instalaciones críticas como aeropuertos, puntos fronterizos, entre otros. El objetivo del experimento era engañar al sistema para que confundiera a Steve (Usuario A) con Jesse (Usuario B), y viceversa.

Para esto, los investigadores emplearon una tecnología conocida como Aprendizaje Automático Adversario (AML, por sus siglas en inglés), cuyo objetivo es engañar a los modelos de inteligencia artificial enviando entradas engañosas. Además, los expertos emplearon un marco GAN (CycleGAN), con la capacidad de transformar una imagen en otra diferente.

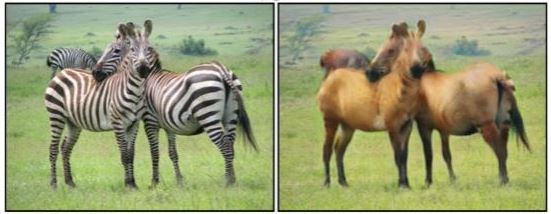

Cabe mencionar que Cycle Generative Adversarial Network (CycleGAN) es un proceso de entrenamiento de redes neuronales para la “traducción” de imagen a imagen. CycleGAN se basa en la modificación de algunas de las características más notables de una imagen (forma de la cabeza, tamaño de los ojos, cejas, etc.).

Cuando todo estuvo listo, el sistema de reconocimiento facial comenzó a detectar de forma normal los rostros de los usuarios A y B; posteriormente, el sistema entrenado por los investigadores comenzó a combinar las características faciales de ambos usuarios, produciendo candidatos que podrían haber pasado como fotos de pasaporte válidas. Los rostros generados por el sistema adversario parecían tan reales que al final fue relativamente fácil engañar al sistema objetivo, que se vuelve incapaz de distinguir un rostro generado por computadora.

El experimento resultó exitoso para McAfee, que anunció que el sistema clasificó erróneamente a los usuarios A y B: “Lo más importante es que este método no compromete la apariencia fotorrealista de un usuario legítimo”, menciona el reporte.

Este es un esfuerzo por señalar la completa dependencia en los sistemas de aprendizaje automático sin considerar sus potenciales fallas de seguridad. Acorde a los investigadores, su objetivo principal es establecer colaboración con los desarrolladores de estos sistemas y encontrar la mejor forma de reforzar su seguridad.

Trabajando como arquitecto de ciberseguridad, el se enfoca en protección de datos y la seguridad de datos empresariales. Antes de unirse a nosotros, ocupó varios puestos de investigador de ciberseguridad con diferentes empresas. También tiene experiencia en diferentes industrias como finanzas, salud medica y reconocimiento facial.